La revista Forbes la ha incluido en la lista de los 40 mejores futuristas de España por liderar la investigación en los aspectos éticos, legales, socioeconómicos y culturales de la inteligencia artificial (IA).

La ingeniera informática Àtia Cortes (Barcelona, 1985), doctorada en IA en la Universidad Politécnica de Cataluña, trabaja hoy en el Departamento de Ciencias de la Vida del Barcelona Supercomputing Center-Centro Nacional de Supercomputación (BSC-CNS). Sus investigaciones se centran en el impacto ético y social de esta tecnología, presente ya en las aplicaciones del día a día.

¿Qué tiene que ver la inteligencia artificial con la ética?

La IA se aplica en muchos ámbitos de la vida y siempre tiene un impacto directo en las personas y, por tanto, unas consecuencias éticas. En particular, para alimentar los sistemas de tomas de decisiones automáticas se necesitan grandes cantidades de datos y se plantean dos retos: uno tecnológico, asegurándose que esos datos sean realmente válidos para entrenar a los sistemas y que tomen decisiones apropiadas; y el otro medioambiental, ya que almacenarlos y procesarlos supone un gran coste energético y con un impacto significativo en el entorno. En centros como el BSC-CNS se desarrolla una gran labor para avanzar en estos campos.

¿Cómo trabajas con la ética y la IA?

En mi día a día trabajo en diferentes proyectos europeos, todos relacionados con los aspectos éticos, legales, socioeconómicos y culturales (ELSEC) de la inteligencia artificial, aplicados a diferentes ámbitos, desde los medios de comunicación, la cultura y el arte, hasta temas de salud o, por ejemplo, en un proyecto que acabamos de empezar enfocado a sistemas de coches autónomos. A partir de ahí, lo que intentamos es identificar cuáles son los posibles retos técnicos, pero también de los aspectos ELSEC, que se presentan para cada campo de aplicación. Así, crear buenas prácticas que ayuden a guiar a la gente que está desarrollando esta tecnología, sobre todo empresas, y hacer un uso responsable de ella.

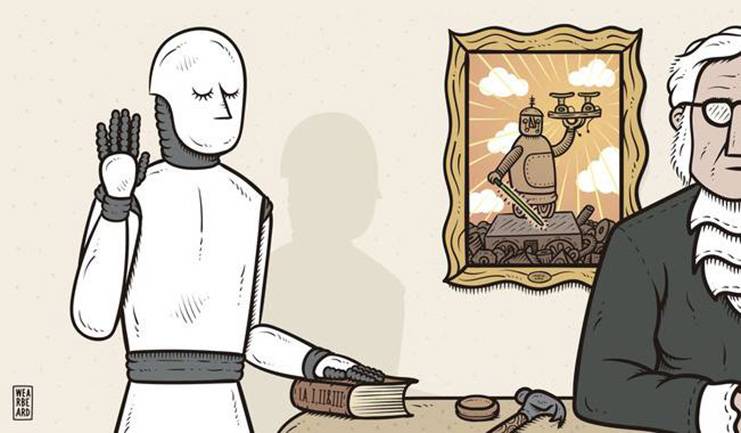

La inteligencia artificial se enfrenta a desafíos éticos. / Wearbeard/SINC

¿En qué consiste el proyecto de coches autónomos que comentas?

Nuestro grupo del BSC va a crear una plataforma para que trabajen los socios de un consorcio europeo, donde estableceremos unos estándares o buenas prácticas para que todo el código que se suba siga unos criterios éticos a la hora de tener conjuntos de datos que sean justos, que estén equilibrados y lo más libres posibles de sesgos. Para asegurar que haya una participación ciudadana en el diseño de esta tecnología, colaboramos con un centro en Francia donde contactarán con usuarios diversos, con diferentes formas de conducir o interactuar en la vía urbana con sus coches, o con necesidades sociales o físicas distintas. Recogeremos todos estos requerimientos y los traspasaremos a las empresas que desarrollan las tecnologías de IA para que los tengan en cuenta.

Ahora te preguntaré por los sesgos, pero al hablar de coches autónomos suele surgir la cuestión de si algún día podrán resolver situaciones como salvar al pasajero o un viandante inesperado que se cruza por delante...

Nosotros no trabajamos en resolver ese tipo de dilemas, que son complicados, y sinceramente, no sé si hay una respuesta porque tampoco es una decisión que tomas tú en el día a día cuando vas conduciendo. No te da tiempo a pensarlo. Entonces, quizá se está pidiendo una decisión compleja a una máquina, que nosotros mismos no sabríamos cómo actuar en esos momentos. Lo que sí que es muy importante, y ahí está la clave, es que, sea cual sea la decisión, seamos capaces de explicar por qué se ha tomado.

Pasamos al problema de los sesgos en la IA, ¿por qué surgen?

La inteligencia artificial al final aprende de lo que tú le estás dando, y si los datos con los que se está entrenando están sesgados, entonces los resultados van a estar sesgados también. La responsabilidad es compartida en varias fases del proceso, pero hay un punto importante al que no se le da suficiente valor, que es cómo se están tratando los datos: toda la parte de preprocesamiento en aprendizaje automático.

Existen grandes datasets o conjuntos de datos disponibles para entrenar los algoritmos, y deberíamos asegurar que la información sea válida, represente realmente lo que queremos aprender y que se haga de una manera justa

Actualmente, existen grandes datasets o conjuntos de datos disponibles para entrenar los algoritmos, por ejemplo, asociados al lenguaje natural o al reconocimiento de imagen. Los desarrolladores tienen la responsabilidad de comprobar que sean válidos. Por muchos datos que tengamos no quiere decir que la información asociada sea apropiada o la que necesitamos. Deberíamos asegurar que esta información sea la que realmente va a representar lo que nosotros queremos aprender y que se haga de una manera justa.

¿Nos puedes poner algún ejemplo de sesgos o injusticias en la IA?

Existen muchísimos ejemplos y lamentablemente algunos son conocidos desde hace bastantes años pero se siguen reproduciendo a veces hoy en día. Uno de los más famosos es el sistema COMPAS en EE UU, que se llegó a utilizar en juicios para dar soporte a la hora de decidir si un delincuente acusado previamente tenía riesgo de ser reincidente o no. Un grupo de investigadores y periodistas se dio cuenta de que este algoritmo estaba sesgado de una manera racial, ya que daba riesgos de reincidencia muy altos a personas negras y bajísimos a las blancas. Con el tiempo se dieron cuenta de que a menudo esta decisión estaba totalmente equivocada, se revisó con qué datos se estaba entrenando el algoritmo y hubo que corregirlo.

Un ejemplo de sesgo racial en la IA fue el sistema COMPAS en EE UU, que daba más riesgo de reincidencia para delinquir a personas negras que a blancas; y de sesgo de genero, una aplicación que probó Amazon para reclutar personal donde se penalizaba a las mujeres

¿Algún caso de sexismo o sesgo de género?

Por ejemplo, hubo una aplicación que comenzó a desarrollar Amazon para ayudar a recursos humanos a reclutar a nuevas personas. Enseguida se dieron cuenta de que este sistema automáticamente estaba descartando a mujeres y, como siempre, los datos de entrenamiento estaban detrás. Se habían tomado los del histórico de los últimos 10 años de los empleados en una empresa tecnológica como esta, donde aparecen desequilibrios de representación entre hombres y mujeres, sobre todo según subes hacia los puestos de dirección. El algoritmo es lo que aprendió, de tal forma que acabó penalizando cualquier currículum que viniera de una mujer, aunque no se especificara el sexo. Lo podía deducir de sus actividades o la información disponible, y al final las descartaba en el proceso de selección. Afortunadamente se dieron cuenta del fallo en una fase bastante inicial y enseguida fue retirado, pero llegó a los medios.

¿Cuántos tipos de sesgos aparecen en la IA?

En los grandes datasets hay un proceso colaborativo en el que, a parte de recopilar datos, se van poniendo metadatos o información adicional a esos datos que ya tenemos y que se van a utilizar para entrenar el. Pues bien, ahí ya se están introduciendo sesgos, porque no hay una forma estándar de clasificar o categorizar, por ejemplo, caras o tonos de piel. Pero existen muchos más sesgos, como los cognitivos, que nosotros como humanos estamos traspasando a los datos de entrenamiento, al algoritmo o a la interpretación de lo que nos da. O los estadísticos, más relacionados con la representación de los resultados, si son equilibrados y están teniendo en cuenta, por ejemplo, diferentes colectivos o, por el contrario, dejan aparte grupos de población por un tema socioeconómico, geográfico, de edad, sexo o lo que sea.

En julio presentasteis un informe al Parlamento Europeo sobre este problema, ¿verdad?

Sí, justo de esto trata el informe. Hacemos una revisión desde un punto de vista tecnológico, explicando cuál es el ciclo que tiene el sistema basado en inteligencia artificial y en qué momento puede ir absorbiendo cada uno de esos sesgos. Luego, en colaboración con la Universidad del País Vasco, que hicieron una revisión del marco legal europeo, proporcionamos recomendaciones de hacia dónde debería ir una posible regulación sobre los datos.

La idea no es crear una nueva ley para esto, porque ya existe el Reglamento General de Protección de Datos y se trabaja en la regulación de inteligencia artificial. Lo que hay que hacer es ver dónde se pueden modificar estas legislaciones y cómo certificar los procesos con una perspectiva ética

La idea no es crear una nueva ley solo para esto, porque ya existe el Reglamento General de Protección de Datos [GDPR, por sus siglas en inglés] y se trabaja en la regulación de inteligencia artificial. Lo que hay que hacer es ver dónde se podrían hacer modificaciones o adaptaciones en estas legislaciones, y sobre todo, cómo certificar estos procesos, siempre con una perspectiva ética.

¿Cuál es tu papel en el Comité de Bioética de España? ¿En qué estáis centrados actualmente?

La formación del nuevo CBE es muy reciente, pero presenta grandes cambios en cuanto a diversidad profesional, geográfica y de género. Su misión es emitir informes, propuestas y recomendaciones para los poderes públicos de ámbito estatal y autonómico sobre temas de actualidad relacionados con la biomedicina y las ciencias de la salud y con unas implicaciones éticas y sociales. En los próximos años aportaré mi conocimiento en IA, ciencia de datos y su impacto en el ámbito de la salud. Personalmente me parece un reto muy atractivo y enriquecedor.

¿Quién es el responsable de que los datos de la IA no estén sesgados?

No solo es del personal que desarrolla la tecnología, están también las administraciones y los legisladores que hacen las leyes. Pero también es muy importante incluir a la sociedad, porque es la que va a usar la tecnología basada en IA y tiene una responsabilidad a la hora de utilizarla, aunque para eso necesita un conocimiento, una educación, que yo creo que todavía no tiene lo suficientemente asumida. Es responsabilidad nuestra, como usuarios, de aprender a interactuar con esta tecnología y a emplearla de una manera responsable. Por tanto, es un trabajo multidisciplinar y a diversos niveles.

La clave está en educar y concienciar sobre lo que es esta tecnología dentro de un marco ético a todos los colectivos implicados: la gente que la está desarrollando, la que elabora las leyes y la sociedad en general, desde los más pequeños

¿Nos podemos fiar entonces de los algoritmos y de su neutralidad a la hora de que nos concedan, por ejemplo, un crédito o una ayuda, o nos recomienden un restaurante, ver un vídeo u leer una noticia?

Como en todo, se necesita información. Para fiarme de algo que va a tener un impacto tan serio en mi vida, como que me concedan un crédito, necesito saber de dónde ha venido esa decisión. Debe haber transparencia, aunque haya que adaptarla al tipo de público que va a pedir la explicación. Es importante aclarar realmente cuáles son las capacidades de esta tecnología y sus limitaciones, cómo se ha entrenado el dataset, cómo se ha llegado a tomar esa decisión. Para mí, eso es fundamental para poderme fiar de un sistema basado en inteligencia artificial. Y en cuanto a temas más culturales, de noticias o el problema de la desinformación, pues al final es un poco lo mismo: ir a buscar la fuente, no creerte lo primero que te encuentras.

¿La IA y la ética podrán ir finalmente de la mano?

Es verdad que la inteligencia artificial ha creado algunas situaciones muy criticadas y que en ocasiones no se ha empleado de una manera apropiada, pero yo soy optimista. Como decía, la clave está en educar y concienciar sobre lo que es esta tecnología, poniéndola en contexto dentro de un marco ético a todos los colectivos implicados: la gente que la está desarrollando, la que elabora las leyes y la sociedad en general, empezando desde la educación más primaria, porque al final los más pequeños serán los que la van a desarrollar y utilizar en el futuro.

. Enrique Sacristán

desde

Creative Commons Crónica CT

Cap comentari :